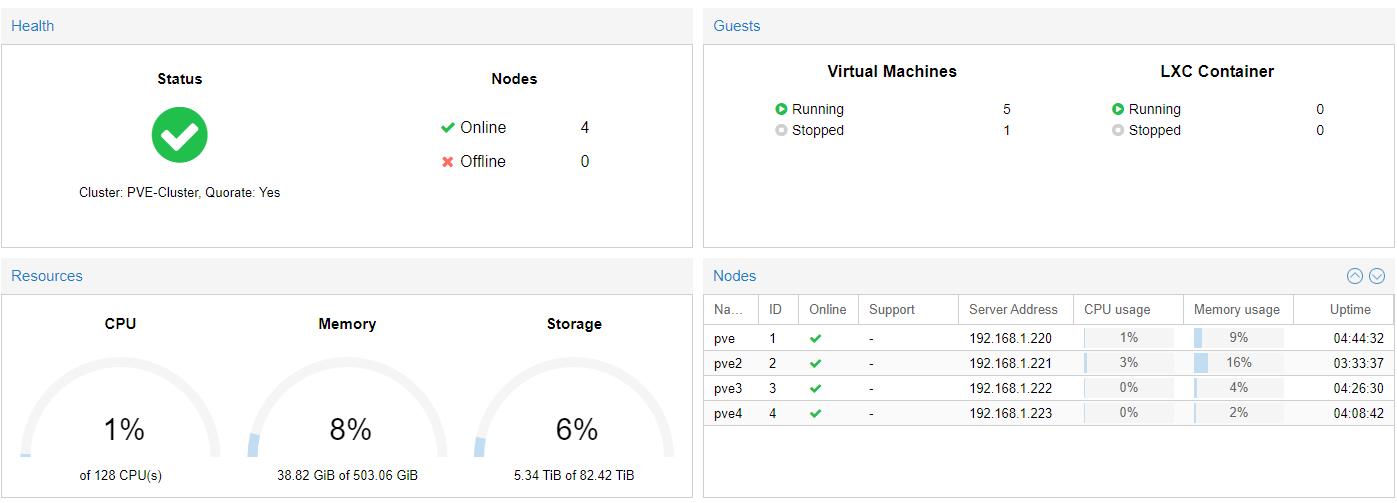

Proxmox 서버의 세팅을 확정짓고 다시 클러스터 설정을 마무리했습니다.

레이드카드를 사용하고있을때

RAID6로 먼저 묶고 ZFS를 쓰는것과

RAID0으로 개별적으로 묶고 ZFS-3를 쓰는것을 비교하고있었는데

후자가 훨씬 유연하고 성능도 잘나와서 나머지 서버들도 모두 새로세팅하고 클러스터로 다시 연결해주었습니다.

이제 이대로 고정하고 서비스 올리는데 집중하려고합니다.ㅎ

마무리는 사양 자랑으로.. 하핫

노드1개에 팰월드 서버를 만들어볼까 싶네요

혹시 같이 하실 분들이 계실까요 ㅋㅋ

1등

1등

행복구슬 2024.01.30. 23:11

우와 멋집니다

2등

SNFAIUWQ 2024.01.31. 01:51

와! 한번 전체 시스템 구경해보고 싶네요

3등

DarkAcid 2024.01.31. 02:39

제 눈이....정상인가요?! 128코어에 500램이라니....ㅎㄷ 합니다.

콜라 2024.01.31. 08:05

호.. 4 개 노드면 ceph는 어떠신가요.

확실히 zfs보다 성능은 많이 떨어지겠지만, 램이 남아돈다면 결국 캐시에서 읽지 디스크에서 읽지 않거든요.

+ 디스크 용량이 1500인 vm도 마이그레이션에 1초컷!

확실히 zfs보다 성능은 많이 떨어지겠지만, 램이 남아돈다면 결국 캐시에서 읽지 디스크에서 읽지 않거든요.

+ 디스크 용량이 1500인 vm도 마이그레이션에 1초컷!

콜라 2024.01.31. 08:07

콜라

전 nvme 두개가 raid되어있는데, proxmox 설정 상에서 캐시 없는 ZSTD zfs랑(zfs는 캐시를 넣으면 느려집니다) proxmox 디스크 설정에서 writeback 캐시가 있는 zstd 압축 ceph 비교해보니, writeback을 하면 쓰기는 10,15%정도 저하가 있고, 읽기는 반토막 정도더군요. 아 저는 로컬 네트워크가 20G(10G 본딩)이긴 합니다.

그럼에도 이걸 한 이유가.. 스토리지 효율이지요.

100기가 여유공간인 디스크 3개가 있으면 150기가 짜리 vm 못만들지만, ceph면 만들수가 있거든요.ㅎㅎ

그리고 ha..

그리고 모든 vm에 마운트 할 수 있는 cephfs까지..

vm 간에 파일 공유도 cephfs에 마운트 한 디렉토리에 넣어서 공유할 수 있습니다!

사실 rbd는 부팅 디스크 전용이고, 모든 파일은 cephfs에 넣어서 관리 할 예정입니다.ㅎㅎ

콜라

아직 배움이 짧아서 서버에 50G hba카드가 있음에도 사용하지않고 있습니다; 하하;

Proxmox에서 활성화 시키는게 어렵더군요ㅠ

Proxmox에서 활성화 시키는게 어렵더군요ㅠ

수라 2024.01.31. 09:01

128cpu 크 ㅎㅎ

오떼블랑 2024.01.31. 15:54

숫자를 잘못 본 줄 알았습니다.

사양이 어마어마하네요.

사양이 어마어마하네요.

cmt alert