시놀로지 -> proxmox -> truenas scale -> truenas core 정착기

안녕하세요 최근에 SDC 고민 작성했던 회원입니다~

회원분들의 소중한 답변을 받아서, 최종적으로 truenas core에 정착하며 겪었던 일들을 작성해보려고 합니다

이전에 올렸던 글에서 나왔던 해결책은 2가지 정도였습니다

1. 시놀로지의 btrfs 파일시스템을 사용하여 주기적으로 데이터 스크러빙을 한다

2. proxmox에 가상화로 zfs 위에 xpenology를 돌린다

첫 번째 방법은 간단해서 바로 작업에 착수했습니다

그런데 믿었던 hyperbackup이 자꾸 배신을 하네요...

복원 도중에 갑자기 "취소됨" 메시지가 출력되고 400gb정도 복원되다가 중단되는 일이 계속 반복되어서,

최종적으로는 복원 데이터를 신뢰할 수 없게 되었습니다

오류 메시지는 권한이 없다고 뜨긴 하는데 onedrive -> webdav(rclone, 내부 serve) -> 시놀로지 단계를 거쳐서 생긴 문제 일 수도 있겠습니다

분명 백업 작업에는 아무런 문제가 없었고, 주기적으로 데이터 무결성 검사도 통과해서 충분히 안정적이라고 봤는데 아니었나봅니다..

그 전에도 시놀로지에 묶여있기 싫다는 생각은 있었는데, 이번 복원 문제로 정이 뚝 떨어져서 시놀로지를 떠나기로 결심했습니다

다행히 외장하드에 따로 hyperbackup 백업 작업을 걸어뒀기에 데이터 복원 걱정은 없었습니다

((외장하드의 데이터를 바로 복원해보면 되지 않냐고 하실 수도있겠지만, 그때 이미 proxmox테스트를 하며 복원해보고 있어서 그럴 수는 없었습니다)

두 번째 방법은 proxmox를 설치해서 가상화로 xpenology를 사용하는 것이었습니다

시놀로지 데이터 복원 작업과 병행하며 j1900 8gb 시스템에 proxmox를 설치하고 xpenology를 테스트해봤습니다

그런데.. 달소님의 가이드대로 진행했음에도 불구하고 samba전송속도가 40~50mb/s 밖에 나오지 않는 것이었습니다

j1900이 i/o를 제대로 감당하지 못하는 것인지 원인은 확실하지 않았지만, 100mb/s 속도를 기대했던 저에게는 턱 없이 모자랐습니다

cpu, ram 자원할당을 이리저리 바꿔도 보고 디스크 관련 설정을 해봤지만, 속도는 비슷했습니다

어차피 사용용도가 명확했던 저에게는 proxmox의 가상화에 큰 메리트를 느끼지 못해서 포기했습니다

세 번째 방법은 truenas scale에 zfs 시스템으로 파일 서버를 구축하고 가상화로 xpenology를 돌리는 방법이었습니다

이전 글에 답변을 주신 분들이 권하지 않는 대표적인 방법이었습니다^^,,,

사실 지금 당장도 dsm의 기능을 활용하는 작업은 파일 공유 링크 생성과 ds file로 사진 백업 밖에 없습니다

따라서 cpu 오버헤드 일으키는 문제보다, 얻는 잇점이 더 많을 것 같다고 판단했습니다

하지만 scale에서 예상치 못한 문제가 2개가 있었습니다

일단 docker-compose가 막혀있습니다

시놀로지를 포기해도 되겠다고 결심한 이유가 docker의 확장성과 간편성이었는데, scale에서는 제대로 지원하지 않습니다

운영체제에서 이미 docker로 많은 서비스를 구동하고 있었고,

그에 따라 시스템의 안정성을 저해시킬 수 있는 작업을 차단한 것으로 보여집니다

따로 우회하면 웹 상에서 docker compose를 사용할 수 있는 것 같지만, 잘 되지도 않았고 좀 복잡합니다

다른 문제는 vm guest에서 vm host로 통신이 불가능합니다

같은 네트워크 대역(192.168.0.0/24)이고 브릿지로 아이피도 할당 받았습니다

인터넷 접근 문제없고 host <-> pc, guest <-> pc간의 ping은 모두 응답하는데 host <-> guest간의 ping은 안 됩니다

관련 내용을 찾아보니까 원래 그렇게 설계되었다고 합니다...?

그래서 해결책의 방법으로 제시된게 guest와 host측에 private망을 구성해서 통신하게 하면 된다고 합니다

이미 앞에서 scale의 장점(docker)이 하나 사라져버렸는데, 굳이 vm만을 바라보고 scale에 남아있을 이유는 없다 판단했습니다

어차피 core에서도 가상화는 지원하니까요

최종적으로 truenas core에 가상화로 xpenology를 돌리는 방법에 정착했습니다

truenas core의 안정성은 이미 오래 지속되어 검증되었고, xpenology를 돌리는 것도 문제가 없었습니다

무엇보다 scale에서는 host와 guest간의 통신이 불가능했는데, core로 오니 기적처럼 문제가 해결되었습니다?!

그래서 따로 내부망을 구성할 필요도 없이 간단하게 문제가 해결되었네요

추가적인 궁금증은 host와 guest간의 내부망 없이 브릿지로 통신할 때,

컴퓨터 내부적으로 루프백이 되는 것인지, 공유기를 거쳐서 다시 돌아오는 것인지 궁금합니다(잘 알고계시는 분이 계시다면 답변 부탁드립니다^^)

xpenology - docker 가동

virtualization - qemu

truenas core - ZFS 시스템

j1900 8gb 시스템

최종적으로는 위와 같은 구성이 되었습니다

zfs를 도입한 것도 좋았고, 기존의 dsm의 장점을 그대로 가져간 것도 무척 만족스럽습니다

저와 비슷한 고민을 하시는 분이 계실까 싶어서, 제 후기를 남깁니다

많은 도움이 되었으면 좋겠습니다!

이상하네요, 시놀로지가 상용으로 그렇게 어설프게 만들리가 없을텐데...

헤놀이 아닌 공식 장비로 Ha구성을 해보신건가요?

시놀로지 ds218+ 사용중입니다

말씀하신 HA 부분은 잘 이해가 가지 않습니다

만약 SDC문제를 시놀로지 장비에서 경험해봤냐고 물으신거라면 대답은 아닙니다 (예전에 사용하던 xpenology에서 볼륨 충돌로 야기된 문제로 추정하고 있습니다)

혹시 hyper backup부분을 물으셨다면, rclone에서 제가 옵션을 잘못 줬을 수도 있고 공식적으로 지원하는 백업 방식이 아니었습니다

시놀로지에서는 그런 문제를 경험하신건 아닌거로군요..

일단 내용상 백업과 관련있는 부분인듯 하여 HA 구성을 말씀 드렸던 부분입니다.

HA는 동일한 시놀로지 장비를 2대 마련하여 1대가 데이터 동기화를 하고 있다가 Active 시놀로지가 문제되면 대기하던 시놀로지로 절체 되는 것을 말합니다. (시스템 구성부터 데이터 까지 모두 절체되어 무중단 시간을 줄일수 있습니다.)

네 HA에 대한 자세한 설명 감사드립니다

가정집 서버에서 HA구성은 필요없다고 판단해서, 혹시 제가 아는 것과 다른 뜻이 있는줄 알았습니다 ㅎㅎ,,

다운 타임을 신경썼다면 RAID까지 구성했겠지만, 제가 가진 환경에서는 백업만으로 충분하다 생각하여 RAID구성은 하지 않았습니다

이번에 정착한 truenas는 zfs 오류 정정 건도 있고, 백업 시스템이 시놀로지만큼은 되지 못한다고 판단해서 RAID를 구성할까 합니다

가진 하드가 8,10tb라 2tb의 손실은 있겠지만, 말씀하신 HA를 생각해본다면 RAID도 다운 타임을 줄이는데 큰 몫을 해낼 것이라 믿고 있습니다~

2등

2등 고생하셨습니다.

속도가안나오는부분은 저도한번 테스트해봐야겠네요!

달소님의 솔루션 제시 덕분에 truenas까지 올 수 있었습니다

원래는 nas os대신 우분투 위에 설치해서 사용해볼까도 생각했지만, 역시나 관리가 문제여서 그만두었습니다 ㅎㅎ

사실 정말 nas목적만 사용한다면 truenas처럼 전문 nas를 사용하는게 가장베스트이지요 ㅎㅎ 목적에따라 잘 선택하신듯 합니다!

추가적인 궁금증은 host와 guest간의 내부망 없이 브릿지로 통신할 때,

컴퓨터 내부적으로 루프백이 되는 것인지, 공유기를 거쳐서 다시 돌아오는 것인지 궁금합니다(잘 알고계시는 분이 계시다면 답변 부탁드립니다^^)

가상머신에 cpu나 램, ssd처럼 가상의 네트워크 망을 연결하는 것입니다.

가상의 랜카드를 만들고, 가상의 스위치(또는 브릿지)를 만드는 것이죠.

가상의 랜카드(network interface card, nic)를 통해 신호가 나가면 가상의 브릿지를 통해 가상 또는 물리 랜카드로 신호가 들어갑니다.

반대도 같아요.

소프트웨어로 구현된 가상의 브릿지로 들어가서 통과하는 것이기에 루프백이라고 하기는 좀 그렇지만,

실제 물리 네트워크 대역폭을 사용하는 것도 아닙니다.

그렇다면 host와 guest 사이에 내부망을 구성하지 않아서 홈네트워크에 추가로 트래픽을 발생시키는 문제는 없겠네요

안심하고 사용할 수 있을 것 같습니다~!!

궁금했던 내용인데 명쾌하게 대답해주셔서 감사드립니다:)

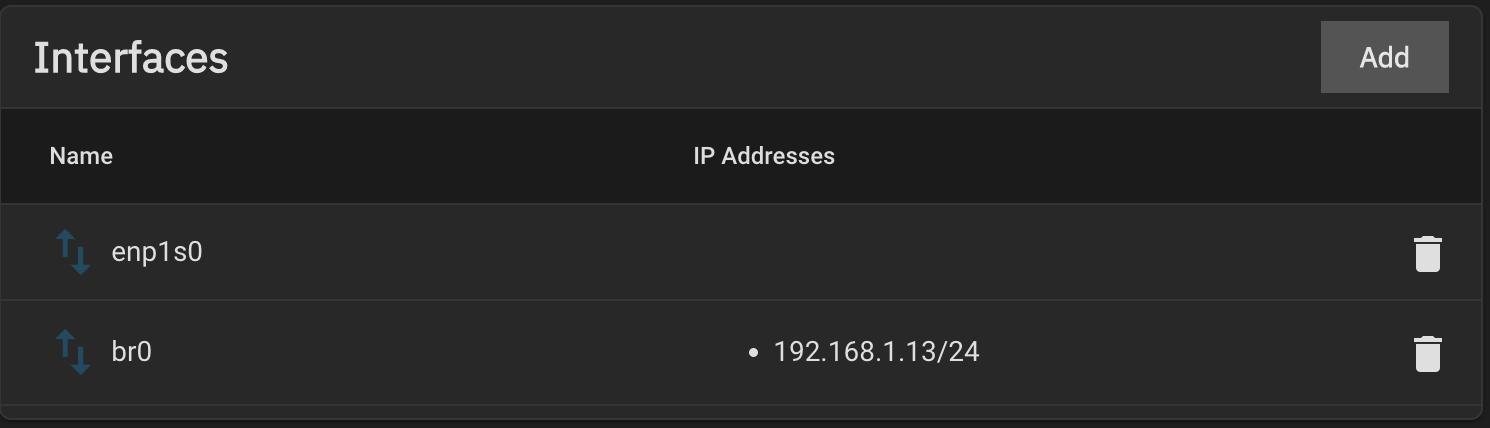

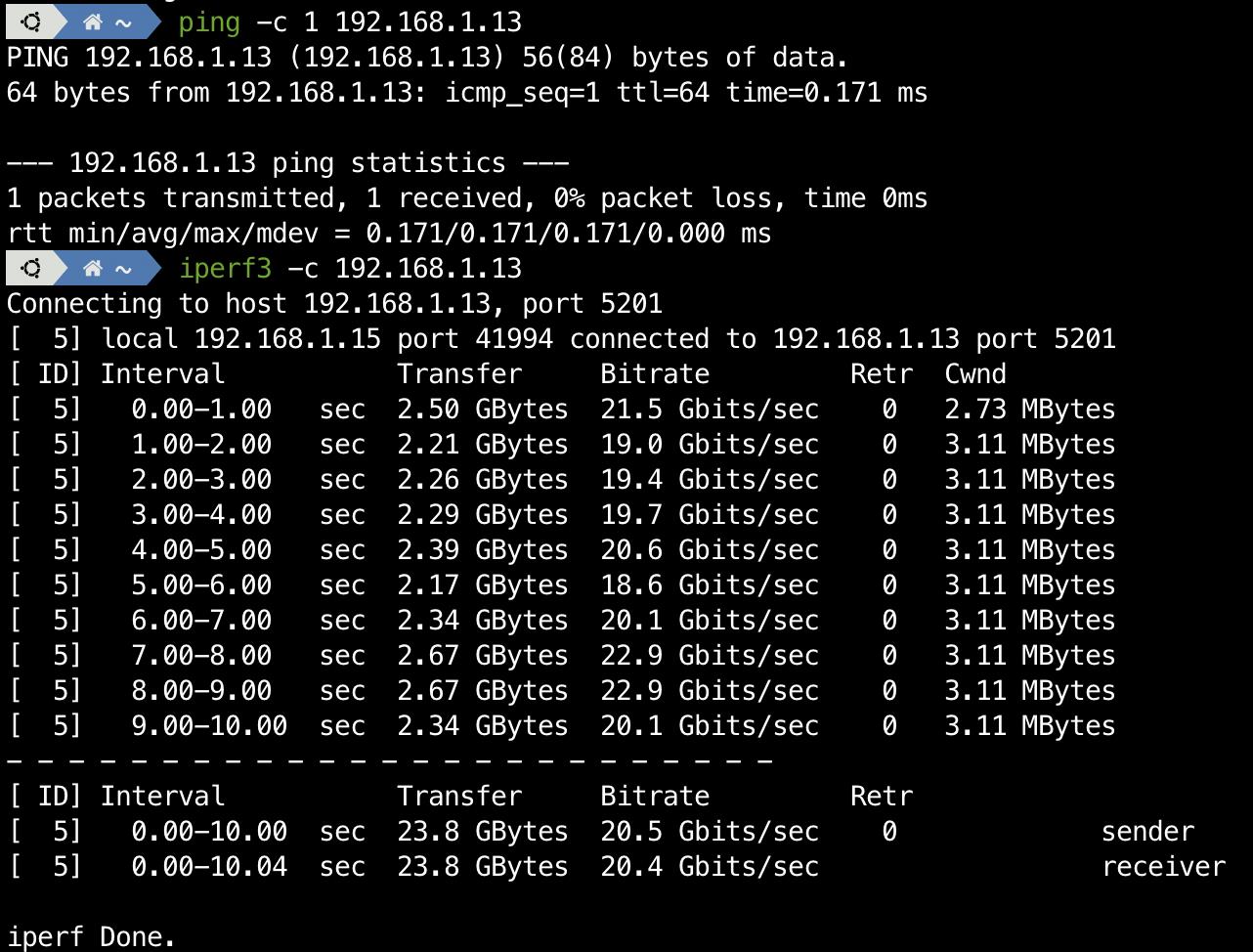

SCALE 사용 중인데, 작성자님 말씀대로 호스트와 게스트간 연결 문제는 브릿지 네트워크로 해결이 가능합니다.

위처럼 설정해 두면 아래 사진과 같이 잘 연결됩니다. (TrueNAS 내 VM에서 테스트한 결과입니다)

핑도 잘 가고 속도도 20기가 대 나오는 거 보니 가상 네트워크로 잘 연결된 것 같고요.

핑도 잘 가고 속도도 20기가 대 나오는 거 보니 가상 네트워크로 잘 연결된 것 같고요.

저도 컴포즈 사용 불가능한 것 보고 "다른 걸로 바꿔야 하나.." 했었는데, 컴포즈에서 일반적으로 설정하는 것들은 웹 UI에서 앱 생성할 때도 똑같이 지원하는 것 같아서 남기로 했습니다. CORE는 데비안 기반인 SCALE과 다르게 FreeBSD 기반이라는 것도 남는 데에 한 몫한 것 같기도 하고요.

scale에서 해결 방법 제시해주신점 감사드립니다~

비슷한 문제를 겪는 다른 회원님께 좋은 자료가 될 거 같습니다

제가 검색한 바로는 shell에 접근해서 직접 qemu를 조작해야 하는줄 알았는데, UI환경에서도 간단하게 해결가능한 부분이었네요

freebsd가 zfs 지원부터해서 장점도 많지만, 역시 사용자 입장에서는 데비안 기반도 무시 못한다는 생각입니다

훗날 서버의 용도가 확장된다면 다시 scale로 회귀할지도 모르겠습니다 ㅎㅎ

지금은 다른 시스템으로 변경했지만 혹시 다시 회귀하게 된다면 시도해보겠습니다 :)

cmt alert